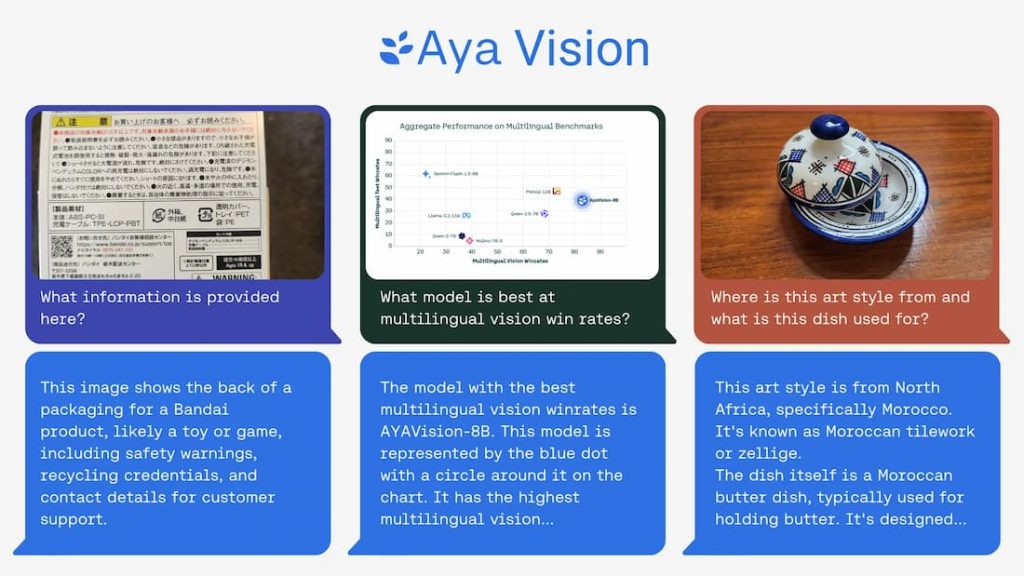

این هفته، Cohere For AI، آزمایشگاه تحقیقاتی غیرانتفاعی استارتاپ هوش مصنوعی Cohere، یک مدل هوش مصنوعی چندوجهی «باز» به نام Aya Vision منتشر کرد و ادعا کرد که این مدل در نوع خود بهترین است.

Aya Vision قادر به انجام کارهایی مانند نوشتن توضیحات برای تصاویر، پاسخ به سؤالات درباره عکسها، ترجمه متن و تولید خلاصهها به ۲۳ زبان اصلی است. Cohere، که این مدل را بهصورت رایگان از طریق واتساپ نیز در دسترس قرار داده، آن را «گامی مهم برای دسترسیپذیر کردن پیشرفتهای فنی برای محققان در سراسر جهان» توصیف کرد.

Cohere در یک پست وبلاگ نوشت: «در حالی که هوش مصنوعی پیشرفتهای قابلتوجهی داشته، هنوز شکاف بزرگی در عملکرد مدلها در زبانهای مختلف وجود دارد — شکافی که در وظایف چندوجهی که شامل متن و تصویر میشوند، حتی بیشتر به چشم میآید. Aya Vision با هدف کمک صریح به کاهش این شکاف طراحی شده است.»

Aya Vision در دو نسخه عرضه شده است: Aya Vision 32B و Aya Vision 8B. به گفته Cohere، مدل پیشرفتهتر، یعنی Aya Vision 32B، «مرز جدیدی» را تعیین میکند و در برخی معیارهای درک بصری، از مدلهایی با اندازه دو برابر خود، از جمله Llama-3.2 90B Vision متا، پیشی میگیرد. در همین حال، Aya Vision 8B، طبق ادعای Cohere، در برخی ارزیابیها از مدلهایی با اندازه ۱۰ برابر خود عملکرد بهتری دارد.

هر دو مدل از طریق پلتفرم توسعه هوش مصنوعی Hugging Face تحت مجوز کریتیو कॉमन्स ۴.۰ همراه با ضمیمه استفاده قابلقبول Cohere در دسترس هستند. این مدلها برای کاربردهای تجاری قابل استفاده نیستند.

Cohere اعلام کرد که Aya Vision با استفاده از «مجموعهای متنوع» از دادههای انگلیسی آموزش دیده است که این آزمایشگاه آنها را ترجمه کرده و برای ایجاد حاشیهنویسیهای مصنوعی استفاده کرده است. حاشیهنویسیها، که بهعنوان برچسب یا تگ نیز شناخته میشوند، به مدلها کمک میکنند تا دادهها را در طول فرآیند آموزش درک و تفسیر کنند. بهعنوان مثال، حاشیهنویسی برای آموزش یک مدل تشخیص تصویر ممکن است به شکل نشانهگذاری اطراف اشیاء یا توضیحاتی باشد که به هر فرد، مکان یا شیء نشاندادهشده در تصویر اشاره دارد.

منبع تصویر: Cohere

استفاده Cohere از حاشیهنویسیهای مصنوعی — یعنی حاشیهنویسیهایی که توسط هوش مصنوعی تولید شدهاند — با روند کنونی همخوانی دارد. با وجود معایب احتمالی، رقبایی مانند OpenAI نیز بهطور فزایندهای از دادههای مصنوعی برای آموزش مدلها استفاده میکنند، زیرا منابع دادههای واقعی رو به کاهش است. شرکت تحقیقاتی گارتنر تخمین زده است که ۶۰ درصد از دادههای مورد استفاده برای پروژههای هوش مصنوعی و تجزیهوتحلیل در سال گذشته بهصورت مصنوعی تولید شدهاند.

به گفته Cohere، آموزش Aya Vision با حاشیهنویسیهای مصنوعی به این آزمایشگاه امکان داد تا با استفاده از منابع کمتر، عملکرد رقابتی را به دست آورد.

Cohere در وبلاگ خود نوشت: «این موضوع نشاندهنده تمرکز حیاتی ما بر کارایی و انجام کارهای بیشتر با محاسبات کمتر است. همچنین این امر پشتیبانی بیشتری را برای جامعه تحقیقاتی فراهم میکند، که اغلب به منابع محاسباتی محدودتری دسترسی دارند.»

همزمان با Aya Vision، Cohere مجموعه معیار جدیدی به نام AyaVisionBench نیز منتشر کرد که برای سنجش مهارتهای یک مدل در وظایف «زبان-تصویر» مانند شناسایی تفاوتها بین دو تصویر و تبدیل اسکرینشاتها به کد طراحی شده است.

صنعت هوش مصنوعی در میانه آنچه برخی آن را «بحران ارزیابی» نامیدهاند قرار دارد؛ نتیجهای از محبوبیت معیارهایی که امتیازهای کلی ارائه میدهند اما با مهارت در وظایفی که اکثر کاربران هوش مصنوعی به آن اهمیت میدهند، همبستگی ضعیفی دارند. Cohere ادعا میکند که AyaVisionBench گامی در جهت اصلاح این وضعیت است و چارچوبی «گسترده و چالشبرانگیز» برای ارزیابی درک چندزبانه و چندوجهی یک مدل فراهم میکند.

با کمی شانس، امیدواریم که واقعاً اینگونه باشد.

محققان Cohere در پستی در Hugging Face نوشتند: «این مجموعه داده بهعنوان یک معیار قوی برای ارزیابی مدلهای زبان-تصویر در تنظیمات چندزبانه و واقعی عمل میکند. ما این مجموعه ارزیابی را در اختیار جامعه تحقیقاتی قرار میدهیم تا ارزیابیهای چندوجهی و چندزبانه را پیش ببریم.»