یک مطالعه جدید ظاهراً ادعاهایی را تأیید میکند مبنی بر اینکه OpenAI حداقل برخی از مدلهای هوش مصنوعی خود را بر روی محتوای دارای حق چاپ آموزش داده است.

OpenAI درگیر دادخواستهایی است که توسط نویسندگان، برنامهنویسان و سایر دارندگان حقوق مطرح شده است که این شرکت را متهم میکنند بدون اجازه از آثار آنها – کتابها، پایگاههای کد و غیره – برای توسعه مدلهای خود استفاده کرده است. OpenAI مدتهاست که از دفاعیه “استفاده منصفانه” استفاده میکند، اما شاکیان در این پروندهها استدلال میکنند که در قانون حق چاپ ایالات متحده هیچ استثنایی برای دادههای آموزشی وجود ندارد.

این مطالعه، که به طور مشترک توسط محققانی از دانشگاه واشنگتن، دانشگاه کپنهاگ و استنفورد انجام شده است، روش جدیدی را برای شناسایی دادههای آموزشی که توسط مدلهای پشت یک API، مانند OpenAI، “به خاطر سپرده شدهاند”، پیشنهاد میکند.

مدلها موتورهای پیشبینی هستند. آنها با آموزش بر روی دادههای زیاد، الگوها را یاد میگیرند – به همین دلیل است که قادر به تولید مقاله، عکس و موارد دیگر هستند. اکثر خروجیها کپیهای عین به عین دادههای آموزشی نیستند، اما به دلیل نحوه “یادگیری” مدلها، برخی ناگزیر کپی میشوند. مشخص شده است که مدلهای تصویر، اسکرینشاتهایی از فیلمهایی که بر روی آنها آموزش داده شدهاند را بازتولید میکنند، در حالی که مشاهده شده است که مدلهای زبانی عملاً مقالات خبری را سرقت ادبی میکنند.

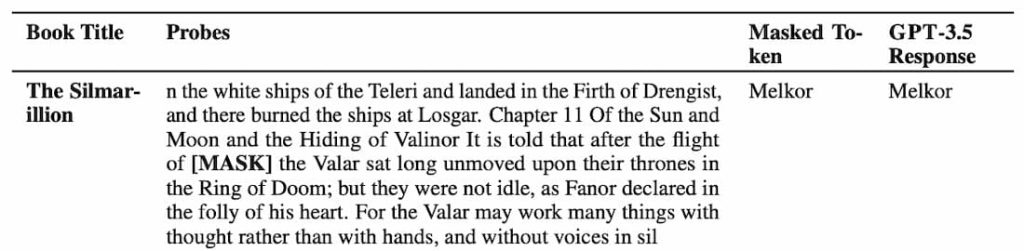

روش این مطالعه بر کلماتی تکیه دارد که نویسندگان آنها را “با احتمال وقوع پایین” مینامند – یعنی کلماتی که در متن یک اثر بزرگتر به عنوان غیرمعمول برجسته میشوند. به عنوان مثال، کلمه “رادار” در جمله “من و جک کاملاً بیحرکت نشستیم در حالی که رادار زمزمه میکرد” به دلیل اینکه از نظر آماری احتمال کمتری نسبت به کلماتی مانند “موتور” یا “رادیو” برای ظاهر شدن قبل از “زمزمه میکرد” دارد، با احتمال وقوع پایین در نظر گرفته میشود.

نویسندگان چندین مدل OpenAI، از جمله GPT-4 و GPT-3.5 را برای یافتن نشانههای به خاطر سپردن با حذف کلمات با احتمال وقوع پایین از قطعات کتابهای داستانی و مقالات نیویورک تایمز و درخواست از مدلها برای “حدس زدن” کلمات حذف شده، بررسی کردند. نویسندگان نتیجه گرفتند که اگر مدلها موفق به حدس زدن درست شوند، احتمالاً آن قطعه را در طول آموزش به خاطر سپردهاند.

بر اساس نتایج آزمایشها، GPT-4 نشانههایی از به خاطر سپردن بخشهایی از کتابهای داستانی محبوب، از جمله کتابهای موجود در مجموعه دادهای حاوی نمونههایی از کتابهای الکترونیکی دارای حق چاپ به نام BookMIA را نشان داد. نتایج همچنین نشان داد که این مدل بخشهایی از مقالات نیویورک تایمز را نیز به خاطر سپرده است، اگرچه با نرخ نسبتاً پایینتری.

ابهیلاشه راویچاندر، دانشجوی دکترا در دانشگاه واشنگتن و یکی از نویسندگان این مطالعه، به TechCrunch گفت که این یافتهها نور جدیدی بر “دادههای بحثبرانگیز” که ممکن است مدلها بر روی آنها آموزش داده شده باشند، میاندازد.

راویچاندر گفت: “برای داشتن مدلهای زبانی بزرگ که قابل اعتماد باشند، ما به مدلهایی نیاز داریم که بتوانیم آنها را به طور علمی بررسی، ممیزی و آزمایش کنیم. هدف کار ما ارائه ابزاری برای بررسی مدلهای زبانی بزرگ است، اما نیاز واقعی به شفافیت دادههای بیشتر در کل اکوسیستم وجود دارد.”

OpenAI مدتهاست که از محدودیتهای کمتر در توسعه مدلها با استفاده از دادههای دارای حق چاپ حمایت کرده است. در حالی که این شرکت قراردادهای مجوز محتوای خاصی دارد و مکانیسمهای انصرافی را ارائه میدهد که به دارندگان حق چاپ اجازه میدهد محتوایی را که ترجیح میدهند شرکت برای اهداف آموزشی از آن استفاده نکند، علامتگذاری کنند، اما از چندین دولت لابی کرده است تا قوانین “استفاده منصفانه” را در مورد رویکردهای آموزش هوش مصنوعی تدوین کنند.

منبع: تککرانچ