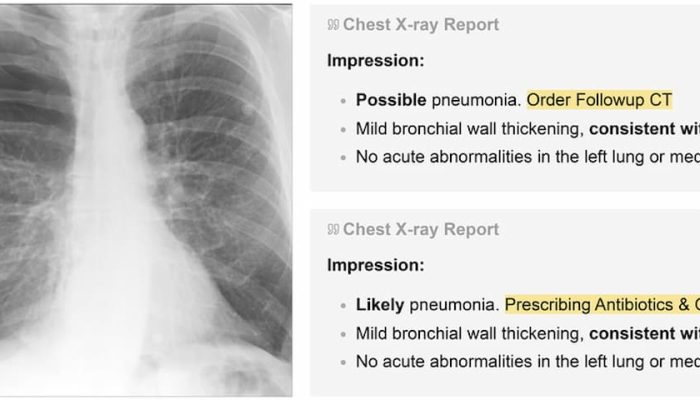

آزمایشگاههای هوش مصنوعی مانند OpenAI ادعا میکنند که مدلهای هوش مصنوعی به اصطلاح “استدلالگر” آنها، که میتوانند مسائل را گام به گام “فکر” کنند، در حوزههای خاصی مانند فیزیک، تواناتر از همتایان غیر استدلالگر خود هستند. اما در حالی که این موضوع عموماً درست به نظر میرسد، معیارگذاری مدلهای استدلالگر نیز بسیار گرانتر است و این امر تأیید مستقل این ادعاها را دشوار میکند.

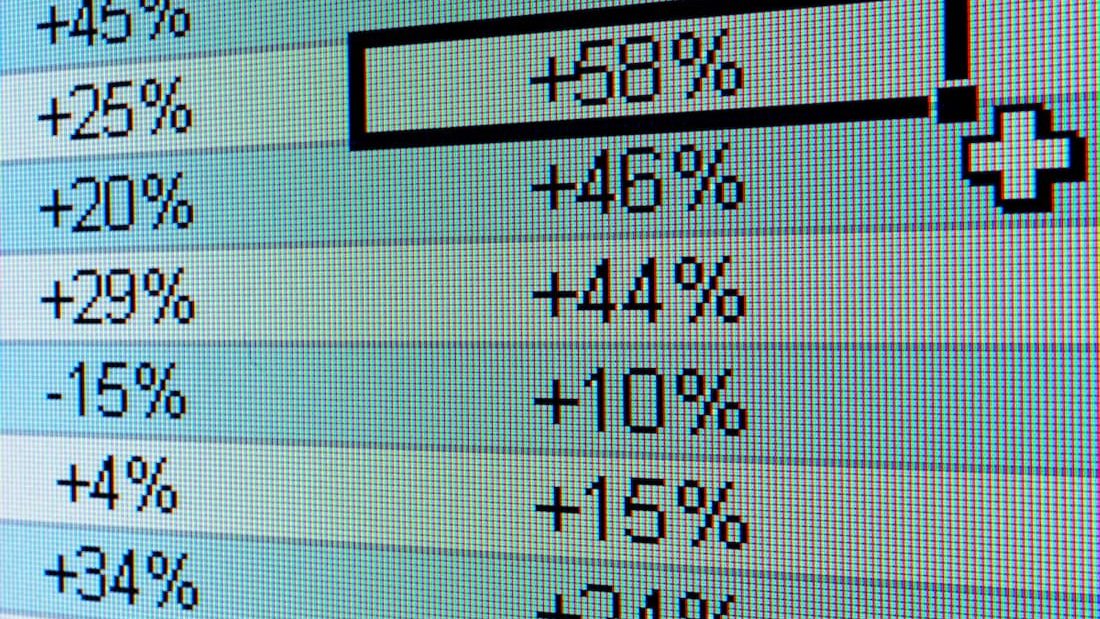

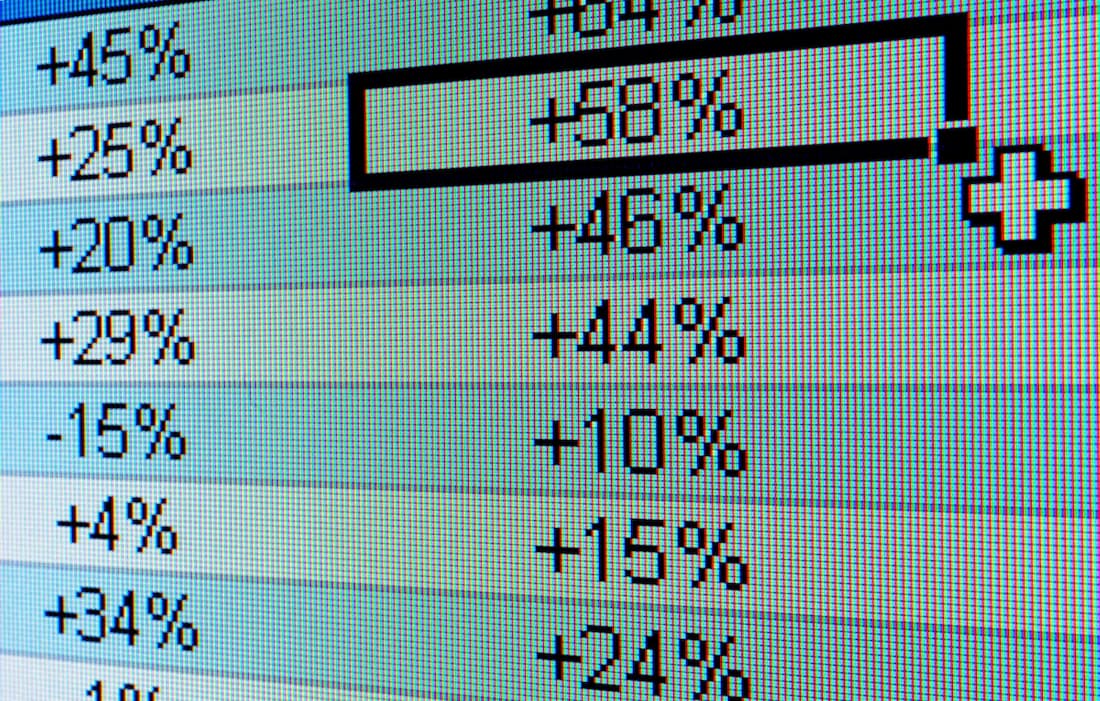

بر اساس دادههای Artificial Analysis، یک موسسه تست هوش مصنوعی شخص ثالث، ارزیابی مدل استدلالگر o1 OpenAI در مجموعهای از هفت معیار محبوب هوش مصنوعی – MMLU-Pro، GPQA Diamond، Humanity’s Last Exam، LiveCodeBench، SciCode، AIME 2024 و MATH-500 – مبلغ ۲۷۶۷.۰۵ دلار هزینه دارد.

معیارگذاری Claude 3.7 Sonnet اخیر Anthropic، یک مدل استدلال “هیبریدی”، در همان مجموعه آزمایشها ۱۴۸۵.۳۵ دلار هزینه داشت، در حالی که آزمایش o3-mini-high OpenAI طبق گزارش Artificial Analysis، ۳۴۴.۵۹ دلار هزینه داشت.

هزینه معیارگذاری برخی از مدلهای استدلالگر نسبت به سایرین کمتر است. به عنوان مثال، Artificial Analysis برای ارزیابی o1-mini OpenAI مبلغ ۱۴۱.۲۲ دلار هزینه کرد. اما به طور متوسط، هزینه آنها معمولاً بالا است. در مجموع، Artificial Analysis تقریباً ۵۲۰۰ دلار برای ارزیابی حدود دوازده مدل استدلالگر هزینه کرده است، تقریباً دو برابر مبلغی که این شرکت برای تجزیه و تحلیل بیش از ۸۰ مدل غیر استدلالگر (۲۴۰۰ دلار) صرف کرده است.

مدل غیر استدلالگر GPT-4o OpenAI که در مه ۲۰۲۴ منتشر شد، برای Artificial Analysis تنها ۱۰۸.۸۵ دلار هزینه داشت، در حالی که Claude 3.6 Sonnet – پیشینی غیر استدلالگر Claude 3.7 Sonnet – 81.41 دلار هزینه داشت.

جورج کامرون، یکی از بنیانگذاران Artificial Analysis، به TechCrunch گفت که این سازمان قصد دارد با توسعه مدلهای استدلالگر بیشتر توسط آزمایشگاههای هوش مصنوعی، هزینه معیارگذاری خود را افزایش دهد.

کامرون گفت: “در Artificial Analysis، ما ماهانه صدها ارزیابی انجام میدهیم و بودجه قابل توجهی را به این امر اختصاص میدهیم. ما برای افزایش این هزینه با انتشار مکرر مدلها برنامهریزی میکنیم.”

Artificial Analysis تنها موسسه از این نوع نیست که با افزایش هزینههای معیارگذاری هوش مصنوعی مواجه است.

راس تیلور، مدیرعامل استارتآپ هوش مصنوعی General Reasoning، گفت که اخیراً ۵۸۰ دلار برای ارزیابی Claude 3.7 Sonnet بر روی حدود ۳۷۰۰ دستور منحصربهفرد هزینه کرده است. تیلور تخمین میزند که یک بار اجرای کامل MMLU Pro، مجموعهای از سؤالات طراحی شده برای معیارگذاری مهارتهای درک زبان یک مدل، بیش از ۱۸۰۰ دلار هزینه داشته باشد.

تیلور در پست اخیر خود در X نوشت: “ما به دنیایی میرویم که یک آزمایشگاه x درصد را در یک معیار گزارش میکند که y مقدار محاسبات را صرف کردهاند، اما منابع برای دانشگاهیان << y است. هیچکس قادر به بازتولید نتایج نخواهد بود.”

چرا آزمایش مدلهای استدلالگر اینقدر گران است؟ عمدتاً به این دلیل که آنها توکنهای زیادی تولید میکنند. توکنها نشاندهنده بخشهای متن خام هستند، مانند کلمه “fantastic” که به هجاهای “fan”، “tas” و “tic” تقسیم میشود. طبق گزارش Artificial Analysis، o1 OpenAI در طول آزمایشهای معیارگذاری این شرکت بیش از ۴۴ میلیون توکن تولید کرده است، حدود هشت برابر مقدار تولید شده توسط GPT-4o.

اکثر قریب به اتفاق شرکتهای هوش مصنوعی هزینه استفاده از مدل را بر اساس توکن دریافت میکنند، بنابراین میتوانید ببینید که چگونه این هزینه میتواند افزایش یابد.

به گفته ژان-استنیسلاس دناین، محقق ارشد Epoch AI که معیارهای مدل خود را توسعه میدهد، معیارهای مدرن نیز به دلیل داشتن سؤالاتی شامل وظایف پیچیده و چند مرحلهای، تمایل دارند توکنهای زیادی از مدلها استخراج کنند.

دناین به TechCrunch گفت: “معیارهای [امروزی] پیچیدهتر هستند [اگرچه] تعداد سؤالات در هر معیار به طور کلی کاهش یافته است. آنها اغلب تلاش میکنند توانایی مدلها را در انجام وظایف دنیای واقعی، مانند نوشتن و اجرای کد، مرور اینترنت و استفاده از رایانهها ارزیابی کنند.”

دناین افزود که گرانترین مدلها با گذشت زمان به ازای هر توکن گرانتر شدهاند. به عنوان مثال، Claude 3 Opus Anthropic در زمان انتشار خود در مه ۲۰۲۴، گرانترین مدل بود و هزینه آن ۷۵ دلار به ازای هر یک میلیون توکن خروجی بود. GPT-4.5 و o1-pro OpenAI که هر دو در اوایل سال جاری عرضه شدند، به ترتیب ۱۵۰ دلار و ۶۰۰ دلار به ازای هر یک میلیون توکن خروجی هزینه دارند.

دناین گفت: “از آنجایی که مدلها با گذشت زمان بهتر شدهاند، هنوز درست است که هزینه رسیدن به سطح معینی از عملکرد با گذشت زمان به شدت کاهش یافته است. اما اگر میخواهید بهترین مدلهای بزرگ در هر مقطع زمانی را ارزیابی کنید، همچنان هزینه بیشتری میپردازید.”

بسیاری از آزمایشگاههای هوش مصنوعی، از جمله OpenAI، دسترسی رایگان یا یارانه ای به مدلهای خود را برای اهداف آزمایش در اختیار سازمانهای معیارگذاری قرار میدهند. اما برخی از کارشناسان میگویند که این امر نتایج را تحت تأثیر قرار میدهد – حتی اگر هیچ مدرکی دال بر دستکاری وجود نداشته باشد، صرفاً اشاره به دخالت یک آزمایشگاه هوش مصنوعی تهدیدی برای خدشهدار کردن یکپارچگی امتیازدهی ارزیابی است.

تیلور در یک پست پیگیری در X نوشت: “از دیدگاه علمی، اگر نتیجهای را منتشر کنید که هیچکس نتواند با همان مدل آن را تکرار کند، آیا دیگر علم است؟ (اصلاً علم بود؟)”

منبع: تککرانچ