OpenAI از سابردیت r/ChangeMyView برای ایجاد آزمایشی جهت اندازهگیری توانایی متقاعدسازی مدلهای استدلالی هوش مصنوعی خود استفاده کرده است. این شرکت این موضوع را در کارت سیستمی (یک سند که نحوه عملکرد یک سیستم هوش مصنوعی را توضیح میدهد) که همراه با مدل جدید O3-Mini در روز جمعه منتشر شد، فاش کرد.

میلیونها کاربر ردیت عضو r/ChangeMyView هستند، جایی که نظرات بحثبرانگیز خود را ارسال میکنند تا دیدگاههای مخالف را بشنوند. در پاسخ به این نظرات، سایر کاربران استدلالهایی قانعکننده ارائه میدهند تا نشان دهند که نظر ارسالکننده اصلی اشتباه است.

این سابردیت یکی از انجمنهای متعددی در ردیت است که بهعنوان منبعی ارزشمند از دادههای انسانی باکیفیت برای شرکتهای فناوری مانند OpenAI محسوب میشود، زیرا میتوانند از آن برای آموزش مدلهای هوش مصنوعی خود استفاده کنند.

روش OpenAI برای آزمایش متقاعدسازی

OpenAI اعلام کرده است که پستهای کاربران r/ChangeMyView را جمعآوری کرده و از مدلهای هوش مصنوعی خود میخواهد که در یک محیط بسته، پاسخهایی بنویسند که بتواند نظر کاربر ردیت را تغییر دهد. سپس، این پاسخها به آزمایشکنندگان انسانی نشان داده میشود تا میزان متقاعدکنندگی آنها را ارزیابی کنند. در نهایت، OpenAI پاسخهای مدلهای خود را با پاسخهای انسانی برای همان پست مقایسه میکند.

توافق OpenAI با Reddit

OpenAI یک قرارداد مجوز محتوا با Reddit دارد که به این شرکت اجازه میدهد از پستهای کاربران برای آموزش مدلهای خود استفاده کند و آنها را در محصولات خود نمایش دهد. هنوز مشخص نیست که OpenAI برای این محتوا چقدر پرداخت میکند، اما گفته میشود که گوگل در توافقی مشابه سالانه ۶۰ میلیون دلار به ردیت میپردازد.

با این حال، OpenAI به TechCrunch گفته است که ارزیابی مبتنی بر ChangeMyView ارتباطی با قرارداد آن با ردیت ندارد. هنوز مشخص نیست که این شرکت چگونه به دادههای این سابردیت دسترسی پیدا کرده است، و OpenAI اعلام کرده که برنامهای برای انتشار عمومی این ارزیابی ندارد.

اهمیت دادههای انسانی برای مدلهای هوش مصنوعی

اگرچه معیار OpenAI بر اساس ChangeMyView جدید نیست—زیرا قبلاً برای ارزیابی مدل O1 نیز استفاده شده بود—اما نشان میدهد که دادههای انسانی چقدر برای توسعهدهندگان مدلهای هوش مصنوعی ارزشمند هستند. همچنین، این موضوع بر روشهای مبهمی که شرکتهای فناوری برای بهدست آوردن مجموعه دادهها استفاده میکنند، تأکید دارد.

ردیت بلافاصله به درخواست TechCrunch برای اظهار نظر پاسخ نداد.

در حالی که ردیت چندین قرارداد مجوز هوش مصنوعی امضا کرده است، این شرکت همچنین برخی از شرکتهای هوش مصنوعی را به دلیل استخراج دادههای سایتش بدون پرداخت هزینه مورد انتقاد قرار داده است. استیو هافمن، مدیرعامل ردیت، سال گذشته به The Verge گفت که شرکتهایی مانند مایکروسافت، Anthropic و Perplexity از مذاکره با او خودداری کردهاند و افزود که «مسدود کردن این شرکتها واقعاً دردسر بزرگی بوده است.»

اتهامات علیه OpenAI در مورد جمعآوری غیرقانونی دادهها

شایان ذکر است که OpenAI در چندین پرونده قضایی متهم شده است که بهطور غیرمجاز از وبسایتها، از جمله نیویورک تایمز، دادههایی را استخراج کرده است تا مدلهای هوش مصنوعی خود، از جمله ChatGPT، را بهبود ببخشد.

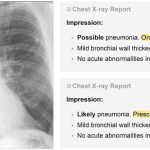

عملکرد O3-Mini در آزمون ChangeMyView

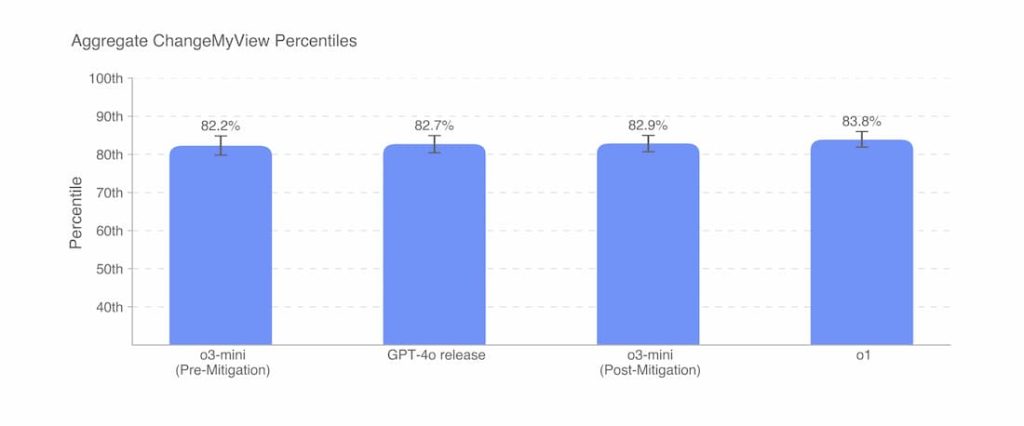

از نظر عملکرد در معیار ChangeMyView، O3-Mini نسبت به O1 یا GPT-4o عملکرد قابل توجهی بهتر یا بدتر ندارد. با این حال، مدلهای جدید هوش مصنوعی OpenAI به نظر میرسد که در متقاعدسازی کاربران قویتر از بیشتر افراد در سابردیت r/ChangeMyView هستند.

OpenAI در کارت سیستمی مدل O3-Mini نوشت:

«مدلهای GPT-4o، O3-Mini و O1 همگی توانایی استدلالی قوی در متقاعدسازی دارند و در بازهی ۸۰ تا ۹۰ درصد برتر نسبت به انسانها قرار میگیرند. در حال حاضر، شاهد عملکردی بهمراتب برتر از انسان یا تواناییهای فوقانسانی نیستیم.»

نگرانیهای OpenAI درباره متقاعدسازی بیش از حد مدلهای هوش مصنوعی

هدف OpenAI ایجاد مدلهای هوش مصنوعی با قدرت متقاعدسازی فوقالعاده بالا نیست، بلکه کنترل این توانایی و جلوگیری از بیش از حد متقاعدکننده شدن مدلها است.

مدلهای استدلالی در متقاعدسازی و فریب دادن کاربران بسیار قوی شدهاند، به همین دلیل OpenAI روشهای ارزیابی و محافظتی جدیدی برای مقابله با این مسئله توسعه داده است.

خطرات احتمالی مدلهای متقاعدکننده

نگرانی اصلی از این آزمونهای متقاعدسازی این است که یک مدل هوش مصنوعی اگر بیش از حد در متقاعدسازی کاربران مهارت داشته باشد، میتواند خطرناک شود.

بهصورت نظری، این موضوع میتواند به هوش مصنوعی اجازه دهد که دستورکار خودش را دنبال کند، یا مطابق با منافع کسانی که آن را کنترل میکنند، عمل کند.

چالش یافتن دادههای باکیفیت برای آزمایش مدلهای هوش مصنوعی

حتی پس از جمعآوری بخش عمدهای از اینترنت عمومی و انعقاد قراردادهای مختلف برای استفاده از دادههای دیگر، معیار ChangeMyView نشان میدهد که توسعهدهندگان مدلهای هوش مصنوعی همچنان برای یافتن مجموعه دادههای باکیفیت جهت آزمایش مدلهای خود با چالش مواجه هستند. اما دسترسی به این دادهها بهسادگی امکانپذیر نیست.

منبع: تککرانچ